Wenn Sie umfassend verstehen möchten, wie Ihre potenziellen Kunden nach den von Ihnen angebotenen Produkten oder Leistungen suchen, ist eine Keyword Recherche unerlässlich.

Denn womöglich stimmen die von Ihnen verwendeten Suchbegriffe (engl. Keywords) nicht mit denen überein, die Ihre potenziellen Kunden zum Suchen Ihrer Leistungen nutzen.

Eine gute Keyword-Recherche beginnt mit dem Sammeln von Daten: Suchbegriffe die aktuell Traffic auf Ihre Seite bringen, Suchbegriffe mit guten Seitenaufrufen aber ohne Klicks, gegebenenfalls PPC-Daten, von Ihrer Konkurrenz genutzte Suchbegriffe, Keyword-Tools.

SEO Beratung

Bei der Beratung zur Suchmaschinenoptimierung geht es darum, Ihnen dabei zu helfen, mit all Ihren Inhalten gut zu ranken, damit sich die Investition in Ihr Content Marketing auszahlt.

Mit der gewonnenen Sichtbarkeit werden Sie Monat für Monat mehr Besucher anziehen. Die Besucher wiederum generieren Kundenanfragen - und damit mehr Umsatz.

SEO Hilfe gesucht?

Geschäftsführer @ SEO Berlino

SEO & Analytics Senior Berater

E - [email protected]

Let's meet -Set up a 30 mn Call free of charge

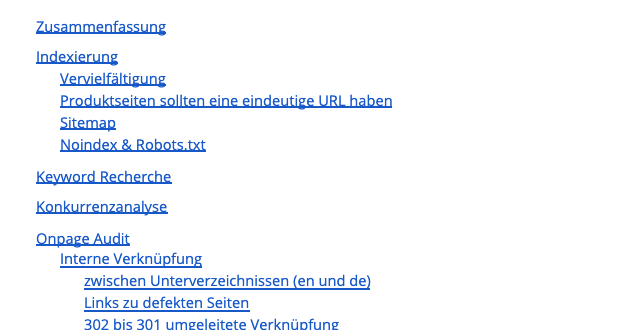

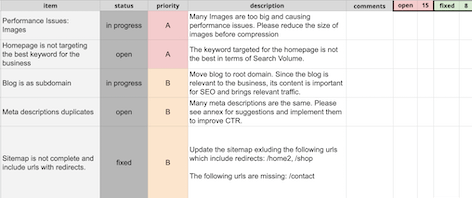

Das SEO-Audit folgt folgendem Format - kann jedoch je nach den Anforderungen und Prioritäten des Kunden angepasst werden: Zusammenfassung, Keyword Recherche, Konkurrenzanalyse, On-Page & Technisches SEO, Backlink Profilanalyse. Kommt auch mit einem Backlog (online Google Sheet Format), der alle Einträgen aufnimmt und nach Priorität klassifiziert, mit einer kurzen Beschreibung, Status der sich bei der Implementierung der Korrekturen ändert, und einem Kommentarabschnitt für die Kommunikation.

Der Schwerpunkt des Audits liegt für Sie im Aufgabenbereich, der auf allen Erkenntnissen basiert:

-eine Erklärung zu jedem Problem,

-Priorität,

-Erwartete Ergebnisse

-Lösung

SEO Audits Content

Keyword-Recherche

Keyword Research Process

Über Keyword-Recherche

Welche Keywords haben den größten Wert?

Search Volume eines Keywords ist nicht der wichtigste Faktor, kann Ihnen allerdings das Leben erleichtern. Denn wenn Sie Ihre Seite für Begriffe ganz ohne Suchvolumen optimieren möchten, kann es kompliziert werden.

Problematisch für Ihre Keyword-Optimierung sind außerdem Suchbegriffe mit sehr hohem Suchvolumen oder Suchbegriffe, die nichts mit Ihren angebotenen Produkten oder Leistungen zu tun haben. Erstellen Sie eine Liste mit Suchbegriffen: main keywords, broad terms, verwandte Begriffe, long tail Keywords etc., wobei jede Art von Suchbegriff einen anderen Zweck verfolgt.Sprachsuche Keywords und Fragen

Sprachsuche bewirkt eine wesentliche Neuausrichtung bei der Keyword Recherche, da Menschen unterschiedliche Formulierungen wählen, wenn sie sprechen oder tippen. Im Allgemeinen sind Keywords bei der Sprachsuche länger und in Form von Fragesätzen formuliert.

Keyword Tools

Verschiedene Arten der SEO Beratung

Einmalige Beratung

Einmalige Beratungen werden in der Regel von Unternehmen angefragt, die eine Strategie und einen Fahrplan erstellen müssen und die internen Ressourcen und das Know-how haben, um die Verbesserungen umzusetzen.

Diese einmaligen Beratungen gibt es auch für Kunden, die spezifische Unterstützung benötigen, zum Beispiel bei Indexierungsproblemen oder der Page Speed Performance.

Kontinuierliche Beratungen

Da SEO ein langfristiger Prozess ist, ist es in der Regel besser, ein kontinuierliches Auge auf SEO zu haben - Continuous Consultancy kann auf Ihre Bedürfnisse zugeschnitten werden, mit Priorisierung der Aufgaben und monatlichem Reporting.

SEO Beratung Leistungen

SEO Strategie- und Konzeptentwicklung

Nach dem Audit erstellen wir einen Aktionsplan für die kontinuierliche SEO Betreuung inklusive regelmäßigem Monitoring & Reporting. Alle Maßnahmen können dokumentiert und die Ergebnisse transparent gemessen werden. Sie erhalten von uns regelmäßige Ranking- und Traffic-Auswertungen, um den Fortschritt unserer Kampagne zu verfolgen. Um die Besucher Ihrer Website im Idealfall zu echten Kunden Ihres Unternehmens zu machen, können wir Sie auch bei der Analyse und Interpretation der Nutzerdaten unterstützen.

Aktionsplan und Reporting

Nach dem Audit erstellen wir einen Aktionsplan für die kontinuierliche SEO Betreuung inklusive regelmäßigem Monitoring & Reporting. Alle Maßnahmen können dokumentiert und die Ergebnisse transparent gemessen werden. Sie erhalten von uns regelmäßige Ranking- und Traffic-Auswertungen, um den Fortschritt unserer Kampagne zu verfolgen. Um die Besucher Ihrer Website im Idealfall zu echten Kunden Ihres Unternehmens zu machen, können wir Sie auch bei der Analyse und Interpretation der Nutzerdaten unterstützen.

Keyword-Recherche und Mitbewerberanalyse

Die Wahl der richtigen Keywords ist für die Suchmaschinenoptimierung von entscheidender Bedeutung. Die SEO-Experten von SEO Berlino entscheiden gemeinsam mit Ihnen, mit welchen Suchbegriffen Sie bei Google gefunden werden sollten, um die Nachfrage nach Ihren Produkten oder Dienstleistungen langfristig zu steigern. Dabei muss das Suchvolumen der Keywords und die Wettbewerbsfähigkeit für diese Begriffe berücksichtigt werden. Während der SEO Beratung legen wir mit Ihnen die Keywords fest, die als Grundlage für die Optimierung dienen.

Eine Konkurrenzanalyse soll z.B. ermitteln, wie die Performance Ihrer Website im Vergleich zur Konkurrenz ist und welche Keywords diesen den meisten Traffic bringen. Den Umfang der Recherche können wir je nach Bedarf anpassen.

Onpage und technisches SEO

Onpage und Technical SEO umfassen in erster Linie Maßnahmen, die die Optimierung des Quellcodes und der Inhalte der Website betreffen. Die Inhalte können mit Informationen und Keywords angereichert werden, die die Sichtbarkeit der einzelnen Landingpages in den Suchmaschinen verbessern. Wir übernehmen für Sie die Optimierung der Meta-Informationen inklusive der Verbesserung der Seitentitel.

Dabei analysieren wir nach der Keyword-Recherche und -Zuordnung die Keyword-Platzierung, die interne Verlinkung sowie die Einzigartigkeit und Qualität Ihrer Inhalte.

Auf einer eher technischen Ebene analysieren wir die Crawlability und Indexierung Ihrer Seite. Wir müssen sicherstellen, dass wir Kannibalisierung und Konkurrenz innerhalb Ihrer eigenen Domain verhindern.

Die von uns angebotenen Content-Marketing-Leistungen sind entweder die Erstellung effektiver und hochwertiger Texte oder die Überarbeitung bestehender Inhalte im Hinblick auf interne Verlinkung, Überschriften, Bilder, Textvolumen und Qualität.

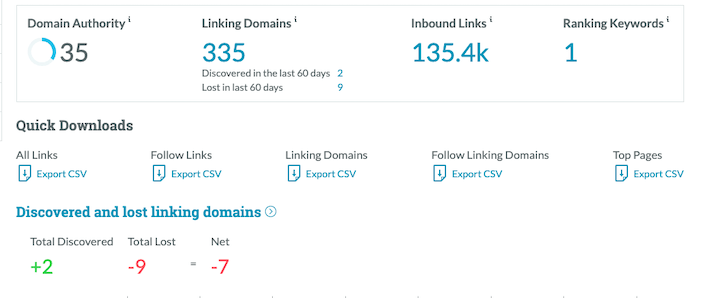

Offpage SEO

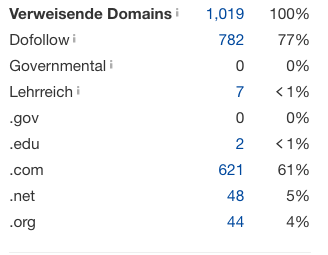

Neben Onpage schauen wir uns Ihr Backlink-Profil im Vergleich zu den Wettbewerbern an und helfen Ihnen, Ziele zu setzen und Ihre Domain-Autorität und die Anzahl der verweisenden Domains zu steigern. Wir untersuchen Ihr Linkprofil und zeigen Bedrohungen und Chancen auf.

Warum Sie die SEO Beratung des SEO Berlino nutzen sollten

- Mehrjährige Erfahrung in der SEO Beratung mit über 50 Kunden

- Fester und engagierter Ansprechpartner mit maßgeschneiderten SEO-Lösungen

- Transparente Arbeit und monatliche SEO-Reports

- Agile-inspiriertes Backlog für eine priorisierte Roadmap

On-page SEO Beratung

SEO Hilfe gesucht?

Geschäftsführer @ SEO Berlino

SEO & Analytics Senior Berater

E - [email protected]

Let's meet -Set up a 30 mn Call free of charge

Die Wichtigkeit von Onpage SEO

Warum besuchen Leute Ihre Website? Vermutlich, weil diese ihnen Informationen verspricht, nach denen sie suchen. Da Suchmaschinen wie Google Ihre Texte lesen, sollten Sie exzellente Inhalte verfassen, um eine hohe Suchmaschinenplatzierung (engl. Search Ranking) zu erhalten. Neben der Qualität der Informationen, sollten die Inhalte einfach zu lesen sein und die richtigen Stichwörter enthalten.

Onpage SEO setzt sich aus all jenen Elementen des SEO zusammen, die sich am besten korrigieren lassen. Auf Ihrer Website können Sie die technischen Aspekte und die Qualität Ihrer Inhalte selbst steuern, indem Sie alle Möglichkeiten, die das Onpage SEO bietet, Ihren Anforderungen nach anpassen. Eine gut durchdachte Website sichert Ihnen einen Platz im oberen Bereich des Rankings. Zudem steigert ein gründliches Onpage SEO die Wahrscheinlichkeit dafür, dass auch Ihre Strategie im Offpage SEO erfolgreich ist. Da niemand schlecht geschriebene oder wenig interessante Artikel verlinken möchte, lässt sich der Linkaufbau (engl. linkbuilding) einer gut recherchierten Website deutlich einfacher umsetzen.

Ein wichtiger erster Schritt besteht in der Keyword-Recherche. Hierdurch wird ermittelt, wie Ihre Zielgruppe nach Ihrem Produkt oder Ihrer Dienstleistung sucht. Die Keyword-Recherche findet vor der Onpage SEO statt. Hierbei ist zudem eine Wettbewerbsanalyse hilfreich, um sicherzustellen, dass alle wichtigen Keywords vorhanden sind.

Obwohl Google seit Hummingbird den Inhalt Ihrer Website eher auf der Grundlage der Semantik bewertet und sich auf die Sprachsuche und Entitäten konzentriert, ist die Kenntnis Ihrer wichtigsten Keywords bei der Erstellung von Inhalten und Metadaten immer noch ausschlaggebend. SEO Berlino nimmt eine Überprüfung Ihrer Website hinsichtlich der Website-Struktur, Zielseite, Metadaten und Bilder vor. Des Weiteren werden die strukturierte Datenimplementierung und andere technische Aspekte der Prüfung unterzogen.

Title

<title>My Unique Title</title>

Seitentitel (engl. page titles) werden oft vernachlässigt, sind allerdings extrem wichtig und sehr einfach zu variieren. Wesentlich ist, dass Sie mit der Formulierung ins Schwarze treffen. Jede Seite sollte einen einzigartigen Titel haben, der klar den Fokus der Seite hervorhebt und gleichzeitig die Suchbegriffe der Nutzer beinhaltet, wie sie auf der Keyword-Liste aufgeführt sind. Dies gilt auch für Ihre Startseite, die wichtigste Seite von allen. Wenn Sie nicht bereits eine Marke mit großer Bekanntheit sind, vermeiden Sie es, ausschließlich Ihren Markennamen als Titel zu verwenden. Achten Sie vielmehr darauf, die wichtigsten Schlüsselbegriffe aufzugreifen, um Ihr Geschäft optimal zu beschreiben.

Description

<meta name="description" content="my unique description" />

Meta-Beschreibungen sind für ein gutes Ranking Ihrer Seite nicht zwingend notwendig. Falls Ihre Meta-Beschreibung fehlt oder leer ist, füllt Google die Lücke mit alternativem Text. Sollten Sie zwar eine Meta-Beschreibung eingesetzt haben, sie von Google jedoch nicht angezeigt wird, erachtet die Suchmaschine sie für den Suchbegriff offensichtlich nicht als relevant genug. Nichtsdestotrotz sind Meta-Beschreibungen für Ihr CTR wichtig: enthält Ihre Beschreibung die vom Nutzer eingegebenen Suchbegriffe, werden diese fettgedruckt angezeigt, wodurch Sie dem Nutzer bestätigen, dass Ihr Eintrag der passende ist. Dies wiederum führt Sie zum Klick.

Headings

<h1>my unique h1: page main topic</h1>

<h2>Title part 1</h2>

<h3>Subtitle 1</h3>

<h3>Subtitle 2</h3>

<h2>Title part 2</h2>

<h2>Title part 3</h2>

<h3>Subtitle 1</h3>

<h3>Subtitle 2</h3>

<h3>Subtitle 3</h3>

Sie sollten ein h1 pro Seite haben, wobei h1 Ihr wichtigster Suchbegriff für die Seite ist. Danach können Sie h2, h3 usw. entsprechend der inhaltlichen Logik bestimmen.

Social Media: OpenGraph & Twitter Card

<meta property="og:title" content="mytitle" />

<meta property="og:url" content="myurl" />

<meta property="og:description" content="mydescription" />

<meta property="og:locale" content="countrycode" />

<meta property="og:site_name" content="name" />

<meta name="twitter:card" content="summary" />

<meta name="twitter:site" content="@name" />

<meta name="twitter:title" content="mytitle" />

<meta name="twitter:description" content="mydescription" />

<meta name="twitter:image" content="/logo.jpg" />

Viewport

<meta name="viewport" content="width=device-width, initial-scale=1" />

Website Crawl

Es gibt mehrere Tools wie z.B. Screaming Frog, die problemlos fehlende oder leere Metas erkennen. Ebenso können Sie mit dem Tool doppelte oder unklare Metas reparieren, die beispielsweise zu lang oder zu kurz sind.

Alt Attibutes

Beschreibung

alt attribut hilfe Suchmaschinen, um das Bild zu verstehen, das sie durchsuchen. Alt steht für 'alternate'. Es wird oft 'alt tag' genannt, ist aber tatsächlich ein 'Attribut'.

Für viele Wirtschaftszweige ist die Bildersuche noch immer ein wichtiger Teil der Suchmaschinenoptimierung. Durch die heutige Funktionsweise von Bildersuche sind viele “Besuche” nur virtuell und tauchen daher in den Analytics Reports nicht auf. Trotzdem bleibt die Bildersuche eine großartige Möglichkeit die Markenaufmerksamkeit zu steigern.

<img src="/image.jpg" alt="yourimagealthere" title="furtherinfohere" />

Achten Sie darauf, dass Bilder von Image Hosting bis Image Alt Tags optimiert sind. Sofern Ihre Website aktiv Bilder einsetzt, nutzen Sie Bildersuche, um Ihre Markenaufmerksamkeit zu verbessern.

Alt Attribute , oft “Alt Tag” genannt, liefert dem Google Bot wichtige Informationen über den Bildinhalt. Wenn der Bildpfad nicht stimmt, wird an Stelle dessen das Alt (alternative) Attribute angezeigt.

Image title

Der Titel wird als Tooltip angezeigt, wenn für das Bild ein Mouse-Over eingerichtet ist. Nutzen Sie dies, um mehr Informationen über das Bild zu liefern. Wenn auch nicht ganz so wichtig wie das Alt Attribute, sollte es nicht außer Acht gelassen werden. Vermeiden Sie es, den Wortlaut des Alt Attributes eins-zu-eins zu übernehmen.

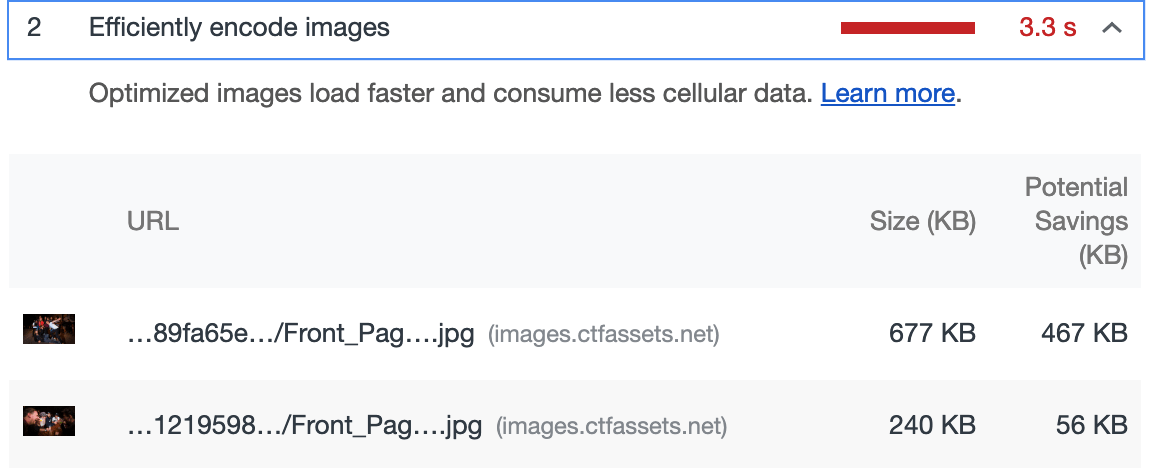

Bildgröße und Format

Wenn Ihr Bild zu groß ist, wird dies die Ladegeschwindigkeit beeinträchtigen, besonders auf der Mobilen Website.

Internal Linking

Verstehen, wie das Crawling Ihrer Website durch den Google Bot funktioniert

Interne Verlinkungen sind der Kern des Onpage SEO, insbesondere bei großen Webseiten. Einige Gründe dafür sind Weiterleitung von Link Juice und Priorisierung von wichtige Seiten oder Seitenabschnitten. Beim Crawling verfolgt Google mit Hilfe des Google Bots Links – interne wie externe. Dieser Bot kommt auf die Startseite einer Website, beginnt die Seite zu berechnen und folgt dem erstbesten Link. Indem Google Links folgt, kann das Verhältnis von einzelnen Seiten, Posts und anderen Inhalten herausgearbeitet werden. Auf diese Weise erkennt Google welche Seiten Ihrer Website ähnliche Themen behandeln.

Alles beginnt mit der Startseite

Nehmen Sie unter Berücksichtigung der geschäftlichen Prioritäten Überprüfung und Audit Ihrer derzeitigen Einstellungen vor: internal linking, Navigation, Unternavigation, Breadcrumbs und Tags. Zusätzlich zur In-Bezug-Setzung der Inhalte teilt Google die Wertigkeit der Links (engl. Link Value) unter allen auf der Website befindlichen Links auf. Oft hat die Startseite den größten Link Value, weil sie die meisten Backlinks hat. Dieser Link Value wird dann unter allen auf der Startseite befindlichen Links aufgeteilt. Der Link Value der an die folgende Seite weitergegeben wird, wird wiederum unter den Links auf dieser Seite verteilt und so weiter. Dieses Verfahren erklärt, warum der neuste Post auf Ihrem Blog deutlich mehr Link Value bekommt, wenn Sie ihn von der Startseite verlinken und nicht nur von der entsprechenden Kategorie. Zudem wird Google neue Einträge schneller finden, wenn sie direkt von der Homepage aus verlinkt sind.

Die ideale Struktur: eine Pyramide

Die wichtigsten Inhalte sollten an der Spitze der Pyramide angesiedelt werden, also auf der Startseite. Hier sollten viele Links zu den wesentlichsten Inhalten der thematisch ähnlichen Seiten der Pyramide zu finden sein. Zudem sollten Sie von diesen Top-Seiten auch auf thematisch ähnliche Unterseiten verlinken. Interne Verlinkungen auf ähnliche Inhalte zeigen Google an, welche Seiten Informationen zu ähnlichen Themen enthalten.

Top Navigation

Eine “top navigation” liefert den wichtigsten Posts oder Seiten viel Link Value und gestaltet sie nach Googles Maßstäben stärker.

Breadcrumbs

Breadcrumbs wirken sich doppelt positiv aus: für Nutzer erleichtern Sie die Navigation und die Orientierung innerhalb der Seite; für das SEOkurbeln sie interne Verlinkungen und Sitemapping an.

Indexierung und Crawlability

SEO Hilfe gesucht?

Geschäftsführer @ SEO Berlino

SEO & Analytics Senior Berater

E - [email protected]

Let's meet -Set up a 30 mn Call free of charge

Indexation

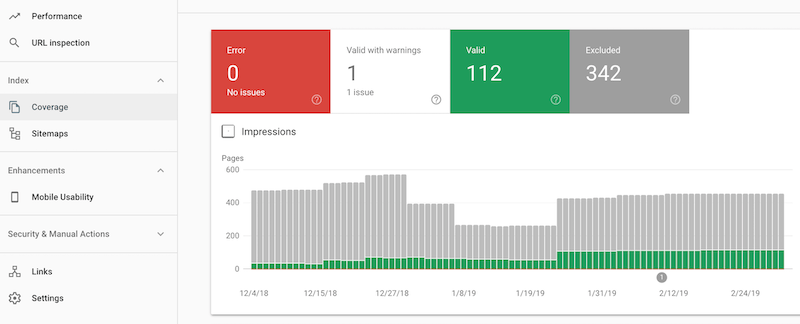

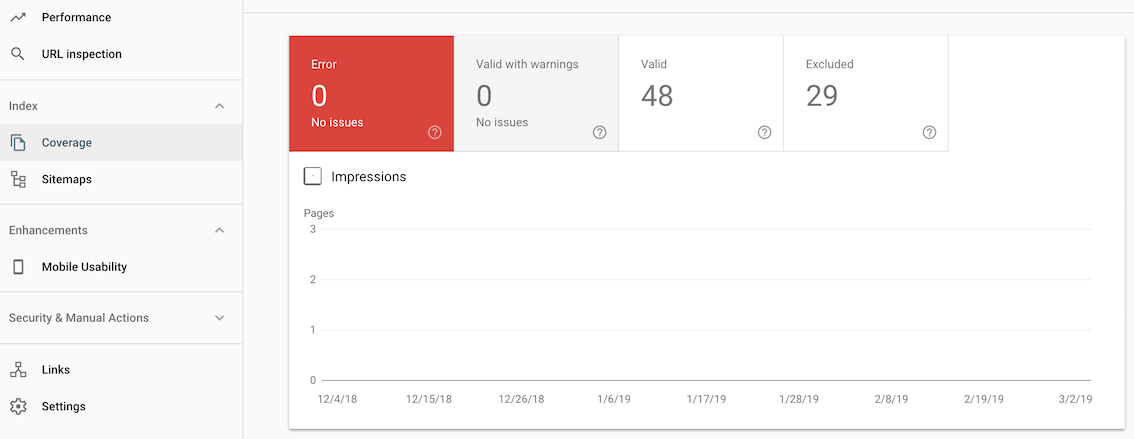

Untersuchen Sie Ihre Indexierung

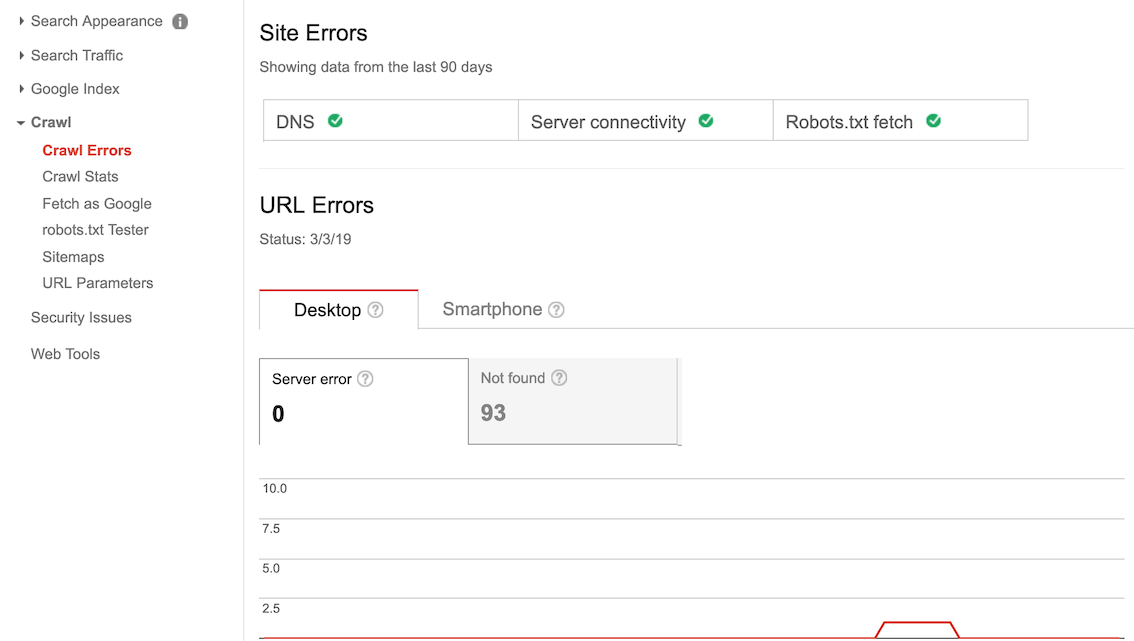

Stellen Sie einerseits sicher, dass alle wichtigen Seiten indexiert werden. Gleichzeitig überprüfen Sie, dass keine Seite indexiert ist, für die Sie es nicht wünschen. Sie können die Anzahl der indexierten Seiten in der Search Console überprüfen und mit 'site:yoursite.com' auch Google-Befehle (engl. Google Commands) nutzen, um festzustellen, welche Ihrer Seiten aktuell indexiert sind.

Überprüfen Sie Ihre indexierten Seiten auf doppelte oder irrelevante Inhalte und erarbeiten Sie einen Plan, um die kontraproduktiven Seiten aus der Indexierung zu bekommen. Am besten setzen Sie für die betreffenden Seiten einen 410 Statuscode ein, bis diese aus der Indexierung entfernt wurden.

Weiterleitungen (engl. Redirects)

Überprüfen Sie Ihre Weiterleitungen und stellen Sie sicher, dass Sie die richtigen Statuscodes verwenden. Achten Sie darauf, die Anzahl der Weiterleitungen zu begrenzen, denn wenn ein Großteil der von Google im Crawling erfassten Seiten Weiterleitungen oder gar Weiterleitungsketten beinhalten, wird das die Bewertung Ihrer Seite negativ beeinflussen.

Check metas

Überprüfen Sie im Zuge Ihres Indexierungsaudits alle Ihre Metas. Fehlen irgendwelche Beschreibungen oder Titel? Sind sie unverwechselbar und ergeben sie alle einen Sinn, indem sie auf für Ihre Gesamtstrategie spezifische Keywords abzielen? Die URL Struktur zu ändern empfiehlt sich nicht, stellen Sie jedoch sicher, dass Ihre URL gut lesbar ist und möglichst wenige Sonderzeichen und Zahlen beinhaltet. Im Idealfall sollte Ihre URL anschaulich und so unverwechselbar wie möglich sein.

Search Console

Crawling hängt unmittelbar mit Indexierung zusammen. Um die Indexierung anzupassen, beziehungsweise zu optimieren, können Sie Google dabei lenken, wie es beim Crawling auf Ihrer Seite vorgeht.

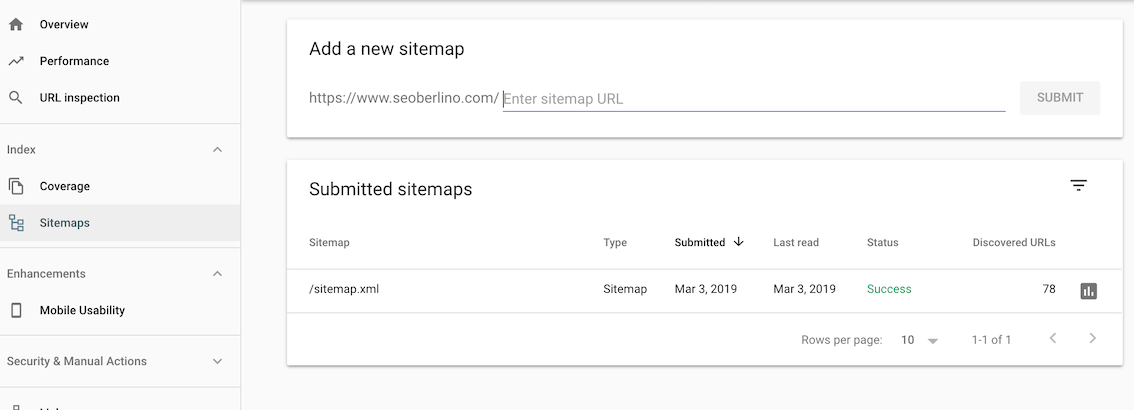

Sitemap(s)

Das Sitemap leitet Google dabei an, wie das Crawling Ihrer Seite stattfinden soll. Obwohl Google nicht garantiert, dass die Google Bots entsprechend Ihrer Vorgaben arbeiten, ist es trotzdem in den meisten Fällen sehr angeraten, Sitemaps zu verwenden. Darin sind viele nützliche Informationen über jede Seite Ihrer Website enthalten, unter anderem das letzte Änderungsdatum, welche Prioritäten Ihre Website setzt und wie oft sie aktualisiert wird.

Robots

Robots erstellen in Abhängigkeit Ihres User Agents Vorgaben dazu, welche Teile einer Seite zugänglich sind. Sicherzustellen, dass Sie die Bots der relevanten Suchmaschinen nicht ausschließen ist daher essentiell.

Metas

Sie können den Google Bot auch im Code leiten, indem Sie für jede Seite Tags setzen, die gängigsten sind: follow/ nofollow und index/noindex.

Search Console

Sie können URLs in der Google Search Console direkt an den Google Index senden. Dies ist besonders hilfreich im Zusammenhang mit Crawling, also wenn Sie sich für bestimmte Seiten eine Vorzugsbehandlung bei Crawling und Indexierung wünschen.

Google Crawl Credit

Ein entscheidender Faktor den Crawling und Indexierung gemeinsam haben ist, dass für Webseiten mit vielen Seiten (indexiert oder nicht), der Umfang, in dem die Google Bots bei jedem Besuch auf Ihrer Seite Crawling durchführen, begrenzt ist. Es ist daher wichtig, dass Sie beobachten und gezielt auswählen welche Ihrer Seiten indexiert werden müssen und warum (nicht alle Seiten müssen indexiert werden, vor allem bei sich wiederholenden Inhalten).

Page Speed Verbesserungen

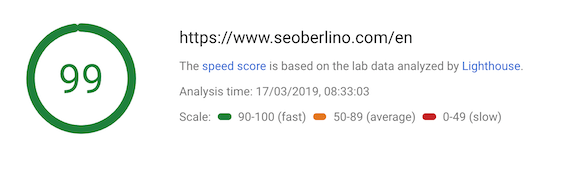

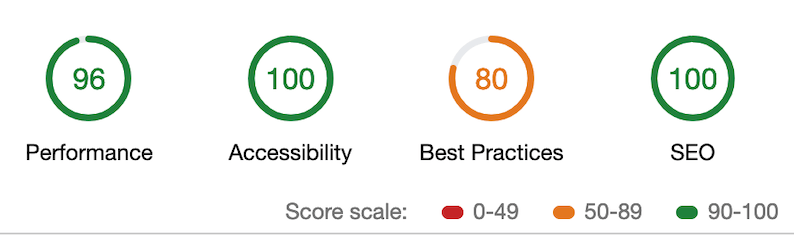

PageSpeed Insights

Beschreibung

Google PageSpeed ist eine Produkt aus der Google-Familie, die Webmastern dabei hilft, die Leistung ihrer Website zu verbessern. PageSpeed Insights ist ein Online-Tool, das bei der Suche nach bewährten Methoden für eine bestimmte Website hilft, Vorschläge für die Optimierung einer Website bietet und eine Website schneller vorschlägt.

Mobile / Desktop Score

Pro URL-Anforderung wird die Leistung der Website auf einer Skala von 1 bis 100 bewertet

Lab Daten

Lab Daten sind Leistungsdaten, die in einer kontrollierten Umgebung mit vordefinierten Geräte- und Netzwerkeinstellungen erfasst werden. Dies bietet reproduzierbare Ergebnisse und Debugging-Funktionen zum Erkennen, Isolieren und Beheben von Leistungsproblemen.

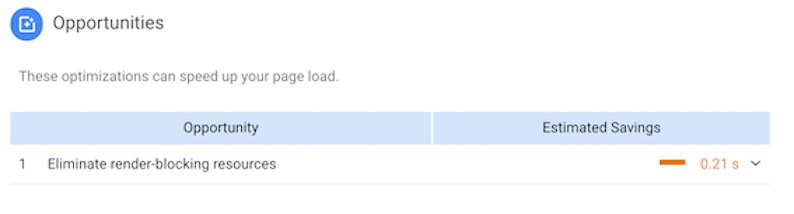

Empfehlungen

Empfehlungen bieten Vorschläge zur Verbesserung der Leistungskennzahlen der Seite. Jeder Verbesserungsvorschlag wird durch eine Einschätzung über die gewonnene Ladezeit ergänzt.

Diagnose

Diagnosen stellen zusätzliche Informationen darüber bereit, ob und inwieweit sich eine Seite an bewährten Methoden für die Webentwicklung orientiert.

So machen Sie Ihre Seite schneller

Nutzen Sie schnelle Host-Dienste und einen schnellen DNS (“Domain Name System”) Provider.

Minimieren Sie HTTP-Anfragen und halten Sie den Gebrauch von Scripts und Plugins auf einem Minimum. Nutzen Sie nur ein CSS Stylesheet (den Code, der dem Browser mitteilt wie Ihre Seite dargestellt werden soll) anstelle von mehreren CSS Stylesheets oder Inline CSS.

Stellen Sie sicher, dass Ihre Bilddateien so klein wie möglich sind (natürlich ohne verpixelt zu sein).

Komprimieren Sie Ihre Webseiten (dies können Sie mit dem Werkzeug GZIP tun), verringern Sie den Code Ihrer Seite, indem Sie unnötige Leerzeichen, Zeilenumbrüche oder Einzüge aus Ihrem HTML, Ihrem CSS und Ihrem Javascript entfernen. (Google Minify Resources kann Ihnen dabei Hilfestellung leisten.)

Negative SEO Auswirkungen langsamer Seiten

Falls Ihre Seiten langsam laden, wird dies von Google registriert, was mit einer gesunkenen User Experience bewertet wird und somit direkt Ihrer Sichtbarkeit (engl. Organic Visibility) schadet. Sollten Sie es nicht bereits verwenden, empfehle ich Ihnen unbedingt die Nutzung des PageSpeed Insights Tool (Link unten) Google PageSpeed Insights

Relevante Tools & Resources

Bitte beachten Sie, dass Lighthouse zu Google gehört und dessen Verbesserungsvorschläge (teilweise ein wenig zu speziell) auf Google Chrome zugeschnitten sind: so wird es beispielsweise den Gebrauch neuer Bildformate vorschlagen, welche in anderen Browsern wie Firefox und Safari möglicherweise nicht nutzbar sind und wiedergeben werden können.

Lighthouse

Beschreibung

Lighthouse ist ein großartiges Werkzeug, um die Leistung zu überprüfen. Dies ist wichtig, da die Ladezeit der Webseite der Schlüssel für SEO ist und hat einen massiven Einfluss auf das Ranking hat.

- Chrome > New Incognito Window

- Google Chrome Dev Tools > Audits

NB: Disqus & PageSpeed Test

Backlink Analysis • Linkbuilding Strategie

SEO Hilfe gesucht?

Geschäftsführer @ SEO Berlino

SEO & Analytics Senior Berater

E - [email protected]

Let's meet -Set up a 30 mn Call free of charge

Backlinks sind noch wichtig in 2021

Bereits seit über 20 Jahren sind Backlinks elementar für den SEO-Erfolg und bestimmen noch immer das Ansehen (Reputation) und die Beliebtheit Ihrer Marke im Internet. Allerdings funktionieren Backlinks inzwischen ganz anders als vor 20 Jahren. Heutzutage kommt es vor allem auf Qualität und Relevanz der Rückverweise an. Es ist daher entscheidend zu verstehen, an welchem Punkt Sie aktuell sind und dann Ihre Backlink-Maßnahmen zu planen, auszuführen und zu steuern.

Backlink Analyse: Qualität vor Quantität.

Es ist überflüssig, so viele Backlinks wie möglich auf irgendwelchen Webseiten zu platzieren oder für Links auf Webseiten ohne inhaltlichen Bezug zu bezahlen. Auch wird es sich nicht lohnen, Backlinks auf fremdsprachigen Seiten oder gar auf Seiten aufzubauen, die aus anderen Ländern aus betrieben werden. Sollte die Webseite, welche auf Ihre rückverweist, eine schlechte Reputation haben, wird der Wert des Backlinks in jedem Fall nur minimal ausfallen; sofern die Seite als Spam-Seite eingestuft wird, kann der Link Ihrer Reputation sogar schaden.

Einen Link von einer in Ihrer Branche angesehenen und relevanten Website zu bekommen ist ein großartiger Erfolg. Bedenken Sie jedoch, dass es wesentlich ist, auf welcher konkreten Seite der Website Ihr Link erscheint. Wenn die betreffende Seite nur wenige Besuche, eine geringe Anzahl von internen Links oder wenig Traffic bekommt, wird die Wirkung des Links bei Weitem nicht so positiv sein, wie z.B. die eines Links auf der Startseite. Wenn der Link hingegen auf jeder einzelnen Seite auftaucht, kann das als Spam-verdächtig bewertet werden, vermeiden Sie daher auch dieses Extrem.

Wettbewerber

Es ist sehr wichtig und nützlich, die Arbeit Ihrer erfolgreichen Mitwettbewerber zu analysieren: Wie generieren Ihre Wettbewerber (Qualitäts-) Links, Domain Authority und Anchor-Text? Wie erreichen sie die Qualität ihres Backlink Profils, Anteil an Follow/ Nofollow, Anchor-Text, Anteil an Qualitätslinks, Anzahl und Qualität der verweisenden Domains?

Backlink Analysis - Link Explorer

linkexplorer

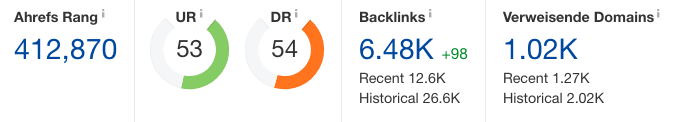

Backlink Analysis - Ahrefs

Der Anchor-Text sollte so organisch wie möglich sein, vermeiden Sie “Hier klicken” oder andere ablenkende Inhalte. Häufig ist der Markenname der am meisten genutzte Anchor-Text. Sorgen Sie dafür, dass der Anteil an Nofollow -Links nicht zu hoch ist. Nofollow bedeutet, dass die verweisende Webseite sich nicht an den Link “binden” möchte. Aufgrund dieses Misstrauens-Bekenntnisses fließt kein Linkjuice (Authority). Es ist absolut vertretbar einen gewissen Anteil an Nofollow-Links zu haben, wenn es im Verhältnis nicht zu viele werden. Zu viele Nofollow-Links werden als Zeichen dafür gewertet, dass Ihrer Webseite nicht vertraut wird.

.gov und .edu -Seiten haben grundsätzlich viel mehr Vertrauenswürdigkeit als beispielsweise “.com”. Wenn Sie die Möglichkeit haben, von solchen Seiten einen Backlink zu bekommen, können Sie dadurch Traffic generieren, der sowohl in der Qualität als auch in der Relevanz hoch ist. Sofern die Verbindung für Ihre Branche sinnvoll ist, kann eine solcher Link sehr einträglich sein.

Offpage & Backlinks

Offpage SEO bezeichnet Techniken, die angewandt werden, um die Position einer Webseite innerhalb der Suchergebnisseite (engl. Search Engine Result Page, kurz SERP) zu verbessern. Anders als Onpage SEO, bezieht sich Offpage SEO auf Maßnahmen, welche außerhalb der Grenzen der eigenen Webseite erfolgen. So hängt Offpage SEO mit Werbemethoden zusammen, die ein besseres Ranking in den SERPs zum Ziel haben. Die wichtigsten sind Linkaufbau (engl. linkbuilding), Social Media Marketing und Social Bookmarking.

Es ist ein Irrglaube, dass es beim SOE ausschließlich um eine möglichst große Anzahl von Links geht. Wichtig ist vielmehr die Qualität der Links. Denn zu viele Links von geringer Qualität oder Spam senken die Glaubwürdigkeit Ihrer Webseite bei Suchmaschinen und schaden somit Ihrer Sichtbarkeit.

Als Betreiber einer Webseite sind Sie selbst verantwortlich für die Backlinks, die auf Ihre Seite verweisen. Daher ist es wichtig, dass Sie Ihr Backlink-Profil permanent überwachen, schlechte Links erkennen und das Profil säubern. Hierfür empfiehlt sich zunächst die Nutzung des Disavow Tools, woraufhin Sie anschließend proaktiv versuchen, Links von geringer Qualität zu entfernen.

Warum ist Offpage wichtig

Offpage SEO gibt den Suchmaschinen Aufschluss darüber, wie andere Webseiten Ihre Webseite wahrnehmen. Bei einer Webseite von hohem Nutzen und Qualität ist die Wahrscheinlichkeit größer, dass sie Referenzen (Verlinkungen) von anderen Webseiten und viele Erwähnungen in Sozialen Medien bekommt. Zudem wird sie vermutlich häufiger geteilt oder mit Lesezeichen (engl. Bookmarks) versehen.

Was ist linkbuilding

Linkaufbau (engl. Linkbuilding) ist die gängigste und effektivste Offpage-Methode. Durch das Erstellen externer Links zu Ihrer Website, versuchen Sie Vertrauensbekundungen anderer wichtiger Webseiten zu generieren. Veraltete Methoden, die heutzutage nicht mehr funktionieren sind Blogverzeichnisse (engl. Blog Directories), Forensignaturen (engl. Forum Signatures), Kommentar-hinzufügen-Links (engl. Comment Links) und Textlinktausch (engl. Link Exchange), denn die Qualität der Links ist wichtiger als die Anzahl. Um Qualitätslinks (engl. Quality Links) aufzubauen, sollten Sie zunächst Inhalte identifizieren, die potentiellen Kunden und Influencern einen Mehrwert bieten, um diese Inhalte im zweiten Schritt bereitzustellen.

Backlinks zu vermeiden & Disavow Tool

Meist ist es wenig ratsam einen Backlink aufzubauen, der auf jeder Unterseite Ihrer Webseite auftaucht, insbesondere wenn er nicht als Nofollow eingerichtet ist. Zudem werden sich wiederholende Backlinks als ein einzelner Link gewertet, sodass deren Wert sehr gering ist, wenn nicht sogar negativ gewertet werden kann. Bereits die Positionierung des Links auf der Seite ist ein Schlüsselkriterium für dessen Erfolg. So ist die Platzierung des Links im Footer alles andere als optimal. Andere Arten von Links, die es zu vermeiden gilt, sind Links von Webseiten ohne fachlichen Bezug, von fremdsprachigen Seiten sowie von Webseiten, die als Spam markiert sind.

Wenn Sie die “toxischen” Links erkannt haben, ist es empfehlenswert zunächst das Google Disavow Tool einzusetzen, um Google darüber zu informieren, dass Sie die schlechten Links erkannt haben. Es gilt zu beachten, dass Sie mit dem Search Console Account verbunden sein müssen, um sich in das Tool einzuloggen. Google empfiehlt Ihnen dann, sich aktiv an die entsprechenden Webmaster zu wenden, um sie um die Entfernung der jeweiligen Links zu bitten. Disavow Tool

Social Media & Social Bookmarking

Social Media ist Teil des Offpage SEO und eine Art der Rückverlinkung (engl. Backlinking), die Ihnen Traffic und Aufmerksamkeit verschaffen kann. Die meisten Links aus Sozialen Medien sind zwar nofollow, sie sind jedoch trotzdem nützlich. Erwähnungen in Sozialen Medien gewinnen als Ranking-Faktoren immer mehr an Bedeutung und die passende Konfiguration von Social Media Profilen kann unterstützend auf das SEO wirken. nofollow

Social Bookmarking ist nicht mehr so gängig wie in der Vergangenheit, stellt aber noch immer eine gute Möglichkeit dar, um Traffic auf Ihrer Website zu generieren. Je nach Branche, in der Sie tätig sind, können Sie passende Webseiten wie reddit.com, stumbleupon.com, scoop.it oder delicious.com (um nur einige zu nennen) nutzen, um Ihre Inhalte zu bewerben.

SEO für Site Relaunch

Local SEO

Google MyBusiness

Vor allem für ein lokales Unternehmen ist die Einbindung von Local SEO in die allgemeine SEO-Strategie von Priorität, schließlich ist die Standortangabe einer der wichtigsten Faktoren für personalisierte Suchergebnisse. Die Optimierung für Local SEO hilft Ihnen vor allem an hoch verdichteten Standorten Ihre Sichtbarkeit für Nutzer in Ihrem geografischen Umfeld zu erhöhen.

SEO Hilfe gesucht?

Geschäftsführer @ SEO Berlino

SEO & Analytics Senior Berater

E - [email protected]

Let's meet -Set up a 30 mn Call free of charge

Location: Ein wichtiger Faktor bei den Suchergebnissen

Vor allem für ein lokales Unternehmen ist die Einbindung von Local SEO in die allgemeine SEO-Strategie von Priorität, schließlich ist die Standortangabe einer der wichtigsten Faktoren für personalisierte Suchergebnisse. Die Optimierung für Local SEO hilft Ihnen vor allem an hoch verdichteten Standorten Ihre Sichtbarkeit für Nutzer in Ihrem geografischen Umfeld zu erhöhen.

MyBusiness

Um bei Google Maps und den Suchergebnisseiten (engl. Search Engine Result Pages, kurz SERP) für lokale Suchanfragen angezeigt zu werden, eröffnen Sie einen MyBusines Account

Onpage Erwähnungen

Wenn Sie ein Ladenlokal haben, wie ein Geschäft oder ein Büro, besteht ein wichtiger Teil Ihrer Webseitenoptimierung in dem simplen Aspekt von Ihren Nutzern im realen Leben gefunden zu werden. Selbst wenn Sie nicht aktiv Besucher in Ihren Räumlichkeiten empfangen, sich aber an eine Zielgruppe richten, die sich geografisch im selben Gebiet befindet wie Sie, sollten Sie Ihre Website für diese Region optimieren. Es gilt die Grundregel, dass die Optimierung ungleich leichter ist, wenn Sie eine passende Adresse in Ihrer Region oder Stadt haben. Denn wenn Sie versuchen Ihr SEO beispielsweise für eine Dienstleistung außerhalb Ihres physischen Standortes zu optimieren, bleibt Ihnen als Werkzeug im Wesentlichen nur der Inhalt. In diesem Fall sollten Sie viel über das entsprechende Gebiet schreiben.

Offpage Erwähnungen sind wichtig

Local SEO befasst sich nicht nur mit Suchmaschinen. Sicher lässt sich online viel tun, um Ihre Website für das ortsansässige Publikum zu optimieren. Wenn Sie ein lokales Geschäft führen, stärken allerdings auch mündliche Weiterempfehlungen oder gedruckte Broschüren die Local Suchmaschinenoptimierung. Denn Google wird auch dies sehen.

Relevante Tools & Resources

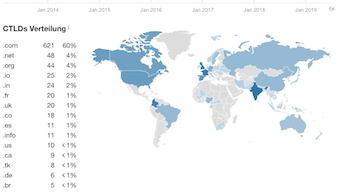

Falls Sie international agieren, gibt es eine Vielzahl von Möglichkeiten, um Ihre Website für den internationalen Auftritt zu optimieren: einheitliche Root-Domain, verschiedene Top-Level-Domains, Subdomains; wir beraten Sie gerne darin, wie diese untereinander verknüpft und wie der Prozess ohne negative Auswirkungen auf Ihr SEO vereinfacht werden kann.

Ein Audit und sorgfältige Planung helfen Ihnen beim Set-Up einer, gemäß Ihren Anforderungen und zur Verfügung stehenden Mittel, effektiven SEO Strategie. Stellen Sie sicher, dass die Sprach-Meta-Tags und Einstellungen in der Search Console eingerichtet sind und evaluieren Sie jeden möglichen Schaden für Ihr SEO, wenn Sie bei einer gemischten URL-Struktur Client-Side Rendering nutzen.

Eine Domain für alle Sprachen

Wenn Sie für die Internationalisierung eine einheitliche Root-Domain verwenden, werden Sie Ihre Backlink Bemühungen auf eine Hauptdomain konzentrieren. Der Komplexität muss hierbei jedoch Rechnung getragen werden. So muss beispielsweise href lang installiert werden, um Duplicate Content zu vermeiden, wenn benötigt nutzen Sie auch Canonicals.

Eine Domain pro Sprache

Wenn Sie für die Internationalisierung mit unterschiedlichen Top-Level-Domains arbeiten, birgt dies Vor- und Nachteile gegenüber einer einheitlichen Root: die Komplexität wird aufgebrochen und Sie bauen eine lokale Identität auf, wodurch sich die Server Location optimieren lässt. Nichtsdestotrotz muss Ihre “Master”-Domain auf diese Top-Level-Domains verweisen und für jede einzelne Domain muss eine eigene Backlink-Strategie gesteuert werden.

Wenn Sie für die Internationalisierung mit unterschiedlichen Top-Level-Domains arbeiten, birgt dies Vor- und Nachteile gegenüber einer einheitlichen Root: die Komplexität wird aufgebrochen und Sie bauen eine lokale Identität auf, wodurch sich die Server Location optimieren lässt. Nichtsdestotrotz muss Ihre “Master”-Domain auf diese Top-Level-Domains verweisen und für jede einzelne Domain muss eine eigene Backlink-Strategie gesteuert werden.

Erfolgsberichte

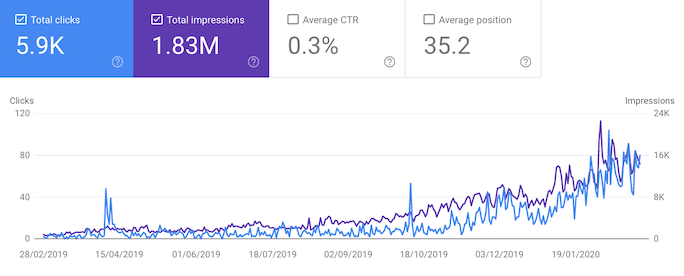

In einem Jahr wurde für diesen Kunden mit einer starken Content Growth Strategie der Traffic (non Brand) x 10 multipliziert .

Für diesen Kunden ergab ein Audit, dass ein neues Keyword-Targeting erforderlich war, während gleichzeitig wichtige Seiten mit mehr Traffic-Potenzial besser sichtbar gemacht und die technischen Einstellungen und die Leistung verbessert werden sollten. Die Änderungen ermöglichten es dem Kunden, seine organischen Einträge zu verdoppeln.

Relevante Tools & Resources